Utiliser Stable-Diffusion avec difficulté pour une tâche qui n’est pas vraiment adaptée, avec un résultat médiocre.

J’essaie des trucs pour que vous n’ayez pas besoin de vous lancer dans une fausse piste.

Vectorisation

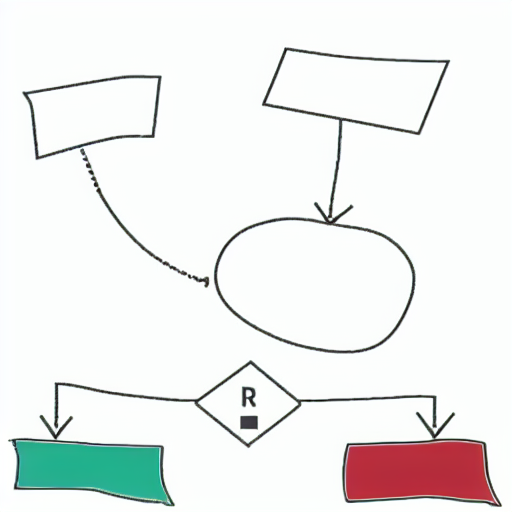

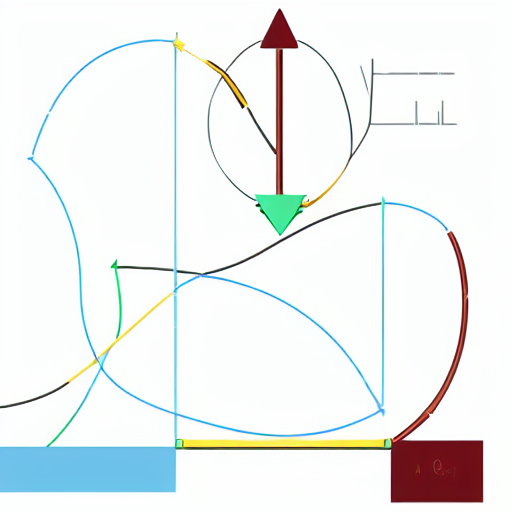

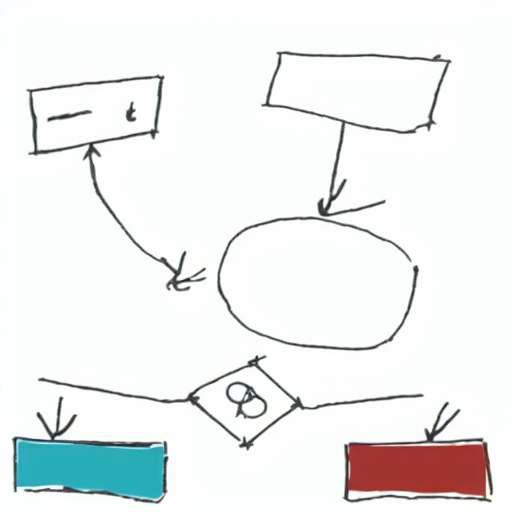

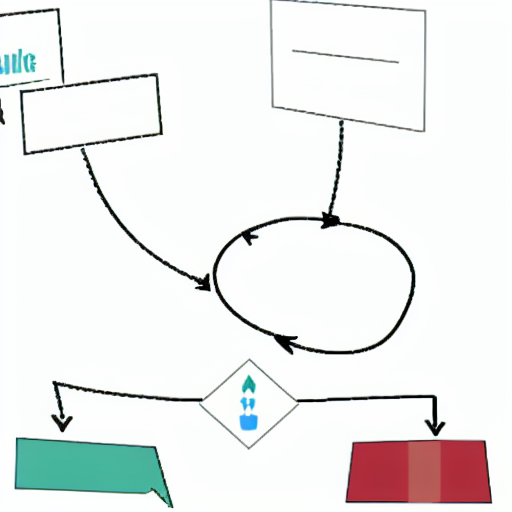

Transformer un diagramme moche tracé à la main à la souris, vers une version vectorielle plus propre, avec img2img:

A flowchart

Steps: 20, Sampler: Euler a, CFG scale: 5, Seed: 4208630417, Size: 512x512, Model hash: 7460a6fa, Denoising strength: 0.49, Mask blur: 4

En réalité, trouver les bons paramètres est très incertain et instable, et il serait sûrement plus rapide d’utiliser une application dédiée. Exemple de résultats foireux:

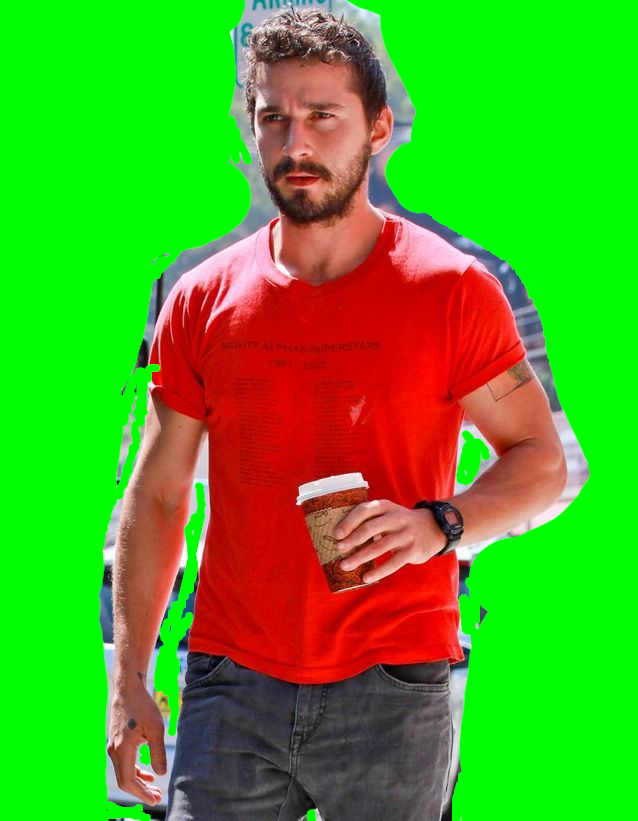

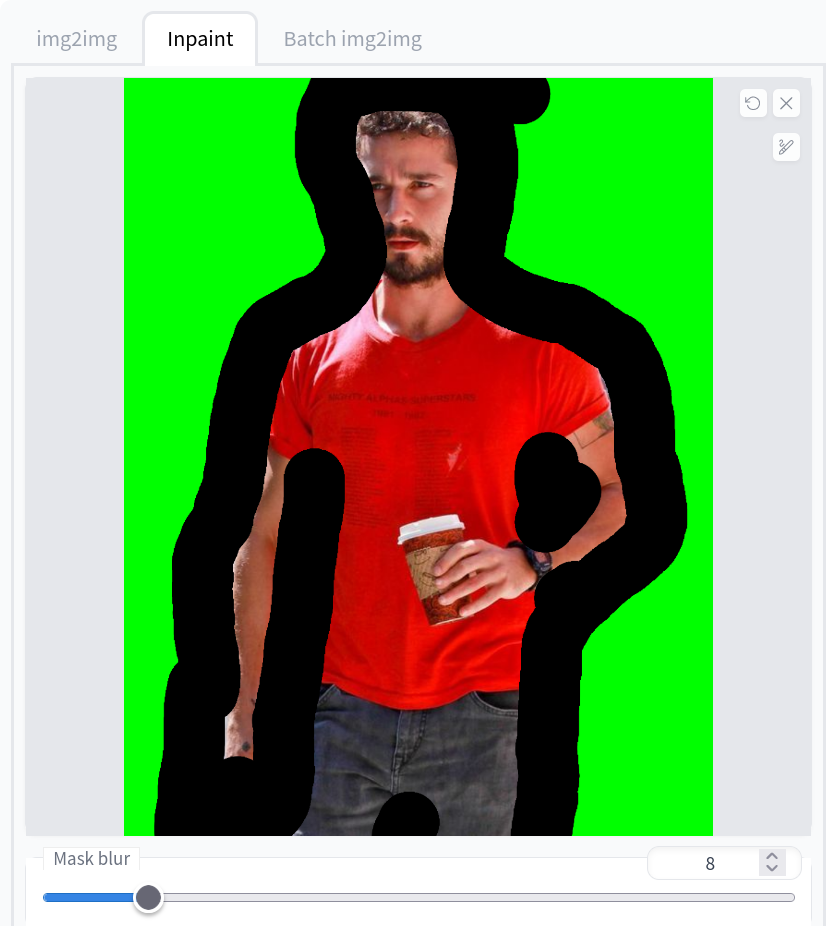

Détourage pour incrustation

On veut parfois récupérer un objet ou une personne détourée sur fond transparent à partir d’une photo normale, sans fond vert bien pratique. Faire un détourage à la main de la silhouette sous gimp étant trop pénible, essayons de faire bosser une IA. Après tout, c’est ce que RunwayML (les auteurs de StableDiffusion) vendent sur leur solution payante https://runwayml.com/green-screen/

Just… Do it !

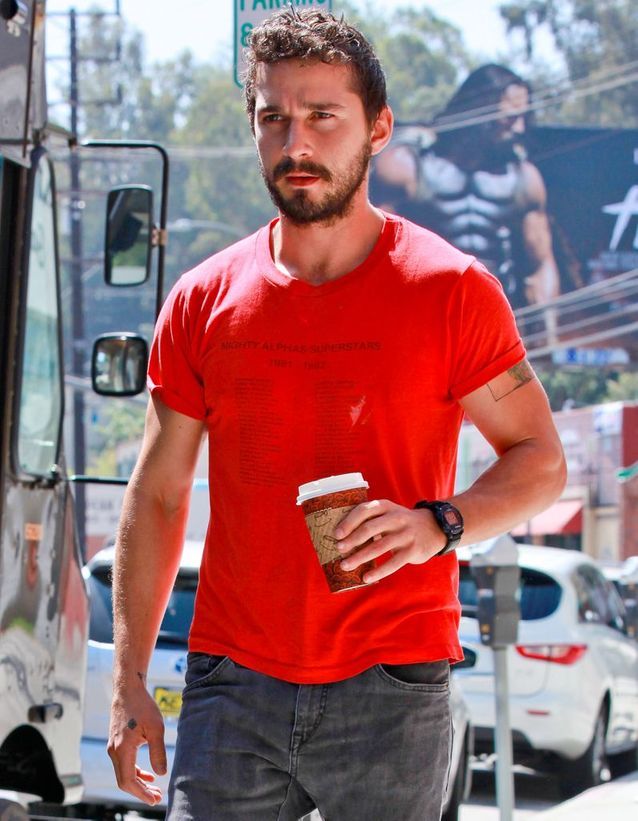

On prend une photo de départ, qu’on gribouille grossièrement en vert dans les zones externes (sans trop faire d’effort de précision) (sans vert déjà existant dans l’image, l’inpainting est incapable d’en générer de lui-même), qu’on importe dans l’onglet inpainting. Ensuite on trace, de nouveau à gros traits, la frontière à affiner. Puis on demande de générer une « photo sur fond vert » du sujet.

L’image générée devrait maintenant avoir un fond vert qui colle à la silhouette. On la réimporte sous gimp et on utilise l’outil de sélection par couleur (Selection Tools -> « By Color Select » Shift-O) sur le vert, qu’on supprime pour avoir de l’alpha.

A photograph of a man in front of a green-screen

Steps: 20, Sampler: LMS, CFG scale: 19, Seed: 1714095486, Size: 640x832, Model hash: 7460a6fa, Denoising strength: 0.72, Mask blur: 8

Tada! ça marche vaguement mais c’est tout moche, et bien sûr les zones recouvertes par l’inpainting ont complétement changé une partie du visage et les cheveux. Encore pire, il a réussi à rajouter du « bleeding » verdâtre là où il n’y en n’avait pas au départ (le bord du coude, par exemple). Inexploitable.

Colorisation de photos noir&blanc

On aimerait qu’un simple img2img avec un prompt « color photo of… » soit assez intelligent pour coloriser de manière pertinente une image de base en noir & blanc. Malheureusement, peu importe le dénoise, le forçage de coefficient du prompt ou des prompts négatifs sur « noir & blanc / monochrome » ça ne fait absolument rien (en poussant beaucoup on arrive à avoir un peu de couleur mais il ne reste rien de l’image initiale).

Dans chaque gallerie suivante, la 1ere image est le point de départ donné à l’algo, plus ou moins préparée à la main:

Le denoise a absolument besoin d’un minimum de couleurs dans l’image de base pour en générer en sortie, on peut penser qu’en rajoutant un peu de bruit de couleur avec un calque gimp en point de départ il en sortira quelque chose. Mais toujours rien, peu importe la forme de bruit initial:

Finalement, on peut essayer de peindre à la main des zones cohérentes avec une base de couleur sans trop de subtilité et espérer que ça guide suffisamment et que ça s’arrange. Mais même en itérant en feedback, les teintes restent identiques et uniformes, les zones ne sont pas remplies jusqu’à leur frontière naturelle, et ce qui bavait continue de déborder.

Rien à en tirer.

Confondre StableDiffusion et Wikipedia

Tableau périodique des éléments:

Trouver le schéma de câblage électrique d’un carillon:

Réviser sa géographie: les cartes sont très ressemblantes mais… faut pas être trop regardant sur la précision des frontières.